La economista Amparo BalliviÃĄn anunciÃģ este miÃĐrcoles 16 de abril de 2025 que ha decidido declinar su precandidatura a la presidencia. Esta decisiÃģn se tomÃģ tras revisar una encuesta interna del bloque de unidad. A pesar de esto, BalliviÃĄn felicitÃģ a Samuel Doria Medina, aunque dejÃģ en claro que no puede brindarle su apoyo.

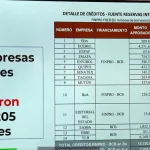

BalliviÃĄn explicÃģ que en la encuesta no obtuvo ni un solo punto. Tras realizar entrevistas con las empresas encuestadoras, llegÃģ a la conclusiÃģn de que Samuel Doria Medina es el candidato que ha ganado en este proceso.

Sin embargo, la economista aclarÃģ que su decisiÃģn de retirarse no significa que estÃĐ apoyando a Doria Medina. En una carta abierta, expresÃģ: “Seguramente me acusarÃĄn de indecisa y muchos etcÃĐteras. Pero yo he prometido, insistentemente, desde febrero de 2024, que apoyarÃĐ al candidato Único de la oposiciÃģn. Hoy Âŋhay candidato Único de la oposiciÃģn? No lo hayâ.

SituaciÃģn de la oposiciÃģn

BalliviÃĄn seÃąalÃģ que en este momento hay dos candidatos de oposiciÃģn que tienen posibilidades reales de ganar las elecciones programadas para agosto. Estos candidatos son Samuel Doria Medina y Jorge Tuto Quiroga. Ambos son fundadores del bloque de unidad, pero ahora estÃĄn divididos en su camino hacia las elecciones.

En este contexto, BalliviÃĄn afirmÃģ que continuarÃĄ trabajando para lograr un candidato Único de la oposiciÃģn. Ella considera que, sin un acuerdo, el Movimiento Al Socialismo (MAS) podrÃa ganar nuevamente las elecciones generales, que estÃĄn fijadas para el 17 de agosto de 2025.

Papel como intermediaria

AdemÃĄs, destacÃģ su posible papel como puente entre Doria Medina y Quiroga. Sin embargo, reconociÃģ que su influencia podrÃa disminuir al declinar su candidatura. âMi propÃģsito serÃĄ estÃĐril si uno o ambos no quieren llegar a un acuerdoâ, afirmÃģ BalliviÃĄn.

Optimismo por un acuerdo

Finalmente, BalliviÃĄn enfatizÃģ su optimismo respecto a la posibilidad de alcanzar un acuerdo entre los candidatos opositores antes de las elecciones. Su compromiso con la unidad de la oposiciÃģn sigue siendo fuerte, a pesar de los desafÃos que enfrenta en este proceso.